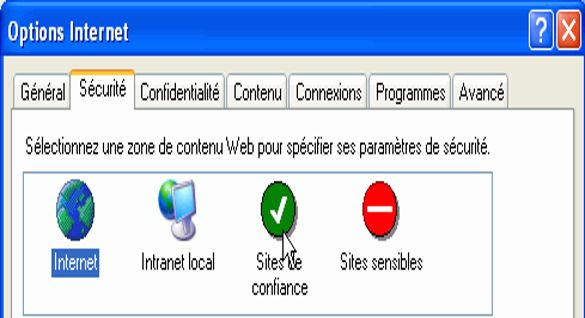

Le sujet des sites de confiance est un sujet propre à l'environnement Windows de Microsoft.... Dans certaines entreprises, ce mécasnime est utilisé pour faciliter les requêtes et notament pouvoir retransmettre correctement le token kerberos. Pour ceux qui ne connaissent pas Kerberos c'est un protocole d'authentification.

Toutefois, par moment les équipes ont configurés tellement de site, qu'il est impossible de vérifier ce qui a été configuré. De ce fait, j'ai écrit ce mini billet afin d'expliquer cette démarche.

La transformation numérique peut être un faux voyage. Voici comment les efforts de transformation low-code et à double voie peuvent aider.

La transformation numérique d'une entreprise à grande échelle peut prendre un certain temps. Les initiatives de transformation telles que la migration vers le cloud, les mises à niveau du mainframe ou la refactorisation de systèmes monolithiques pourraient facilement prendre cinq à sept ans. Pourtant, ce rythme lent est en contradiction directe avec les normes d'innovation numérique d'aujourd'hui et la pression pour publier rapidement des logiciels.

Non, je ne fais pas référence à terminator ou à un terminal d'aéroport... Vous êtes sur un site de Geek aux dernières nouvelles. Microsoft est en train de dépoussiérer son terminal afin de le faire rentrer dans l'époque moderne. A présent, via le Microsoft Store vous pouvez récupérer Windows Terminal qui a pour objectif de regrouper les différents outils en ligne de commande et les shells disponibles sous Windows : Invide de commande, Powershell, Azure Cloud Shell, et bien sur WSL (Windows Subsystem for Linux).

C'est le rapport car cela date du 19 mai 2020 et nous sommes en 2021 ? et bien, je voulais juste faire un petit rappel des possibilités du terminal. Car il ne faut pas l'oublier, mais avec .net5 il est plus que facile de déployer des applications compatible avec Linux. Or un serveur Linux est nettement plus facile à administrer qu'un serveur Windows (Du moins si vous en avez les connaissances pour le faire). Bref, pour ceux qui ont envie de commencer de tater de la ligne de commande, je me suis dit qu'un petit billet sur les commandes ne fera pas de mal.

Je ne sais pas si vous avez suivi l'actualité dans le monde numérique, mais cela donne l'impression qu'une révolution est en train de couver.

Entre le nombre de moteurs de recherche qui arrivent sur le marché qui explosent ces derniers temps, dont l'objectif est de concurrencer les mastodontes (les GAFAM...) Dont on peut citer DuckDuckgo, Qwantz, etc. Ou encore lorsque les gouvernements eux-mêmes décident d'aller à l'encontre de Facebook comme l'australie. Je me dis clairement, le marché est train de basculer. Pour une fois, c'est l'europe qui a mis le feu aux poudres de cette révolution qui est en cours en mettant en place la RGPD afin de remettre les personnes aux centres du débat et leur permettre de choisir volontairement d'être le produit ou non.

Si vous utilisez IIS sur les serveur Windows de Microsoft, vous pouvez utiliser complétement les fonctionnalités pour gérer les accès de vos serveurs web de manière efficace avec Windows Admin Center ou encore Powershell. Dans cette article, j'ai cherché à fournir les opportunités des outils Microsoft qui facilitent l'utilisation et l'administration des sites IIS. Vous pouvez facilement faire ces opérations avec la version 2019 Server et de multiple outils comme IISAdministration module en powershell.

La ligne de commande sur Windows Server offre également un moyen de gérer vos sites web avec appcmd ou encore iisreset. Mais c'est également possible d'utiliser des outils graphique, toutefois ces derniers ne sont pas accessible lorsque nous utilisons une version Core Server, ou au sein d'un conteneur. Ainsi, je pars du postulat que vous avez configuré votre serveur avec la version 2019, toutefois, en grande majorité de ce qui vous sera transmis pourra sans aucun doute s'appliquer pour Windows Server 2012 R2 ou encore 2016.

FancyZones est un utilitaire de gestion de fenêtres permettant d'organiser et d'aligner les fenêtres dans des mises en page efficaces afin d'améliorer la vitesse de votre flux de travail et de restaurer rapidement les mises en page. FancyZones permet à l'utilisateur de définir un ensemble d'emplacements de fenêtre pour un bureau qui sont des cibles de glissement pour les fenêtres. Lorsque l'utilisateur fait glisser une fenêtre dans une zone, la fenêtre est redimensionnée et repositionnée pour remplir cette zone.

Le didacticiel suivant est l'étape suivante dans Apprendre à créer un framework d'automatisation de test avec C #, Selenium 3 et Nunit: cette étape concerne le modèle d' objet de page (également connu sous le nom de modèle de conception d'objet de page ou d'objet de page) et les raisons de l'implémenter lorsque créer votre cadre d'automatisation de test.

Si nous regardons en arrière, le développement d'applications appartenait traditionnellement aux ingénieurs et aux services informatiques de chaque entreprise. Et dans une large mesure, c'est toujours le cas. Cependant, de nouveaux joueurs ont récemment rejoint le jeu, et il semble qu'ils sont là pour rester!

Les développeurs citoyens sont désormais une étape importante en matière de création d'applications plus rapide avec moins de retouches. Selon Gartner, un développeur citoyen est un utilisateur qui crée de nouvelles applications métier destinées à être utilisées par d'autres en utilisant des environnements de développement et d'exécution sanctionnés par l'informatique d'entreprise.